Künstliche Intelligenz wird vielseitiger

Forschung am Fachgebiet Intelligent Autonomous Systems

11.01.2021 von Boris Hänßler

Neuronale Netze lösen gut spezielle Aufgaben. Aber im Gegensatz zu uns Menschen können sie die einmal gelernte Strategie schwer auf andere Aufgaben übertragen. TU-Forscher ermöglichen dies nun.

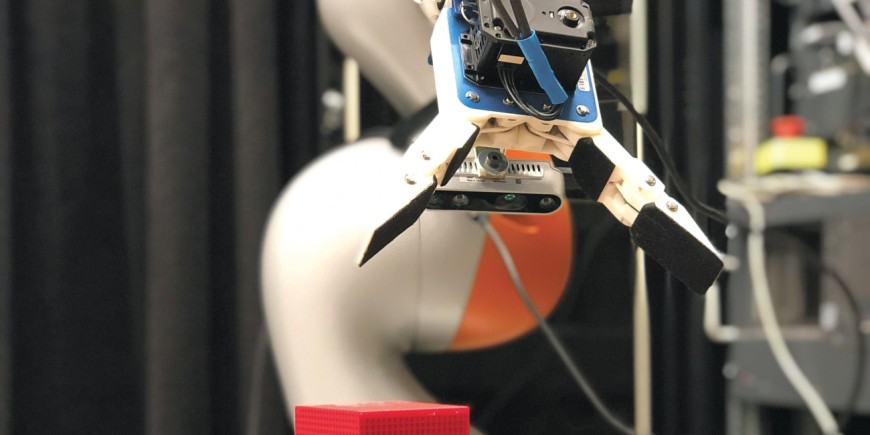

Ein Kind soll sein Spielzeug sortieren und aufräumen. Es gelingt ihm problemlos, weil es weiß, wie man aufräumt und wo was hingehört. Schließlich hat es das schon hunderte Male getan. Nun bitten die Eltern ihr Kind, künftig auch beim Aufräumen in der Küche zu helfen und den dortigen Müll zu sortieren – eine neue Aufgabe. Das Kind erlernt sie trotzdem schnell, weil es das Prinzip des Sortierens verstanden hat. Es muss nur durchschauen, wo was hingehört. Ein Roboter, dessen „Gehirn“ ein neuronales Netz ist, kann ebenfalls lernen, Spielzeug aufzuräumen. Gibt man ihm aber die Aufgabe, den Müll zu sortieren, fängt er wieder bei null an.

Neuronale Netze sind dem Gehirn nachempfunden. Sie lernen wie ein Mensch, indem beim Training sogenannte Synapsen – in diesem Falle Parameter – gestärkt werden, und zwar jedes Mal, wenn ein Trainingsversuch erfolgreich ist. Je stärker die entsprechenden Synapsen, desto zuverlässiger funktioniert das Netz. Aber bei einer neuen Aufgabe ist das Gelernte wieder vergessen. „Insbesondere Deep Learning-Netze sind gut darin, spezialisierte Aufgaben zu erlernen, aber die der Lösung zugrundeliegende Struktur zu extrahieren und auf andere Aufgaben zu übertragen – das war bisher eine offene Forschungsfrage“, erläutert Doktorand Daniel Tanneberg von der Intelligent Autonomous Systems (IAS) Group der TU Darmstadt. Seine Kollegen und er haben nun eine neuronale Computerarchitektur entwickelt, die genau dies leistet. Sie beschreiben ihr System – den Neural Harvard Computer (NHC) – in einer Publikation, die in der Fachzeitschrift Nature Machine Intelligence erschienen ist.

Strategien von einem Problem auf das andere übertragen

"Aus der Lernforschung ist bekannt, dass für intelligentes Verhalten gerade die Fähigkeit relevant ist, Strategien von einem Problem auf ein anderes übertragen zu können“, sagt Tanneberg. Das neuronale Netz müsse daher so verallgemeinert konzipiert sein, dass es sowohl mit anderen Daten als auch anderen Aufgabenstellungen zurechtkomme. Erst dann zeige es intelligentes Verhalten.

Der NHC ist eine speichergestützte, netzwerkbasierte Architektur. Die Forscher ergänzten ein klassisches neuronales Netz durch mehrere Module, etwa einen externen Speicher, der es ermöglicht, eine weitere Abstraktionsebene einzuführen. Dabei werden die Informationsströme aufgeteilt und die algorithmischen Operationen von den Datenmanipulationen entkoppelt. Das Netzwerk trennt das Gelernte, das die konkreten Daten betrifft, von den gelernten allgemeinen Strategien. Für einen Roboter wäre die Unterscheidung der Spielzeuge die eine Ebene, das Sortieren an sich die andere – in neuronalen Netzen waren bisher beide Ebenen in der synaptischen Gewichtung kodiert und somit nicht getrennt.

Anhand von elf Aufgaben konnten die Forscher nachweisen, dass der NHC algorithmische Lösungen mit starker Verallgemeinerung zuverlässig lernt und auf beliebige Aufgabenkonfigurationen übertragen kann. „Das hat den immensen Vorteil, dass das Netz schneller eine neue Aufgabe meistert, da nur die datenspezifischen Operationen angepasst werden müssen“, sagt Tanneberg. Das spart Ressourcen, da neuronale Netze oft hohe Rechenleistungen und eine Menge an Trainingstagen beanspruchen. Ein weiterer Vorteil ist, dass sich solche Netze besser erklären lassen, da sie mehr Einblicke in die Lernprozesse und das Verhalten nach dem Lernen gestatten. Die neue Architektur kann eine Chance sein, neue und unerwartete Strategien zu entdecken, die sich das Netz aneignet. Auch uns Menschen kann es schließlich nicht schaden, ein noch intelligenteres Verhalten zu lernen.