Wächter gegen anstößige Bildinhalte

Forschungsteam des AIML stellt innovatives Sicherheitstool „LlavaGuard“ vor

10.07.2024 von Felix Friedrich/Claudia Staub

Forschende am Fachgebiet Künstliche Intelligenz und Maschinelles Lernen (AIML) des Fachbereichs Informatik der TU Darmstadt und des Hessischen Zentrums für Künstliche Intelligenz (hessian.AI) haben eine Methode entwickelt, mit der sich erstmals mithilfe von Vision-Language Models bestimmte Bildinhalte in großen Datensätzen oder von Bildgeneratoren filtern, bewerten und unterdrücken lassen. Die Forschung ist Bestandteil des Clusterprojekts „Reasonable Artificial Intelligence (RAI)", das bei der Exzellenzstrategie des Bundes und der Länder einen Vollantrag für die Förderlinie „Exzellenzcluster“ gestellt hat.

Mithilfe von Künstlicher Intelligenz (KI) können Objekte in Bildern und Videos identifiziert werden. Dieses computergestützte Sehen (Computer Vision) lässt sich auch verwenden, um große Mengen visueller Daten zu analysieren.

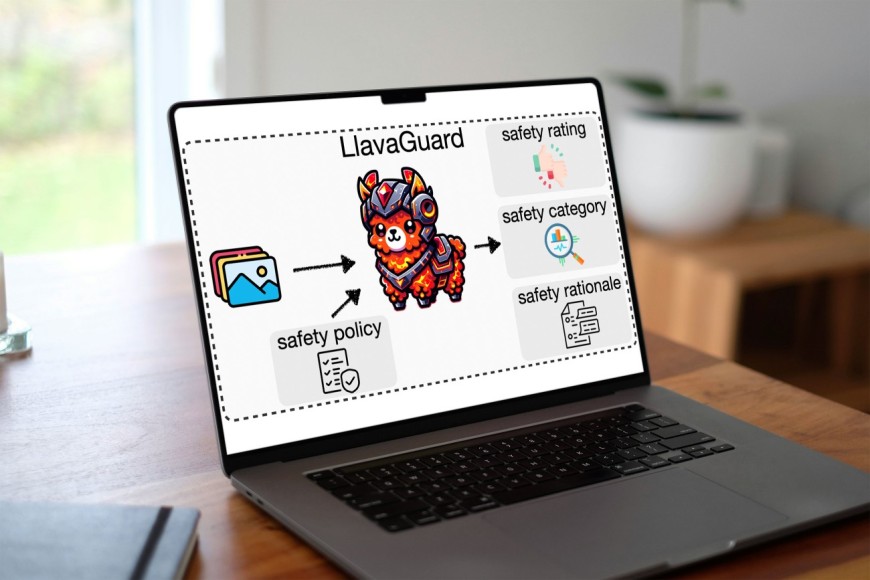

Forschende um Felix Friedrich vom AIML haben eine Methode namens „LlavaGuard“ entwickelt, mit der sich nun bestimmte Bildinhalte filtern lassen. Das Tool nutzt dazu sogenannte Vision-Language Models (VLMs). Im Gegensatz zu Large Language Models (LLM) wie etwa ChatGPT, die nur Text verarbeiten können, sind Vision-Language Models in der Lage, Bild- und Textinhalte gleichzeitig zu erfassen.

Transparenz sorgt für Vertrauen

„LlavaGuard“ kann zudem auch sehr komplexe Anforderungen erfüllen, denn er zeichnet sich durch seine Fähigkeit aus, sich an verschiedene gesetzliche Bestimmungen und Anforderungen von Nutzenden anzupassen. So kann das Tool beispielsweise zwischen Regionen unterscheiden, in denen Aktivitäten wie etwa Cannabiskonsum legal oder illegal sind. Zudem kann „LlavaGuard“ bewerten, ob Inhalte für bestimmte Altersgruppen angemessen sind und diese entsprechend einschränken oder anpassen. „Derartige Sicherheits-Tools gab es bislang nur für die Analyse von Texten. Bei der Filterung von Bildern lässt sich derzeit nur die Kategorie ‚Nacktheit‘ umsetzen, nicht aber andere wie etwa ‚Gewalt‘, ‚Selbstverletzung‘ oder ‚Drogenmissbrauch‘“, sagt Friedrich.

Dabei kennzeichnet „LlavaGuard“ problematische Inhalte nicht nur, sondern liefert detaillierte Erläuterungen zu seinen Sicherheitsbewertungen, indem es Inhalte in Kategorien einteilt (zum Beispiel „Hass“, „illegale Substanzen“, „Gewalt“ etc.) und erklärt, warum sie als sicher oder unsicher eingestuft werden. „Diese Transparenz ist das Besondere an unserem Tool und entscheidend für Verständnis und Vertrauen“, erklärt Friedrich. Es mache „LlavaGuard“ damit zu einem unschätzbaren Werkzeug für Forschende, Entwickler:innen und politische Entscheidungsträger:innen.

Sicherheit erhöhen, schädliche Inhalte verringern

Die Forschung zu „LlavaGuard“ ist ein integraler Bestandteil des Clusterprojekts „Reasonable Artificial Intelligence (RAI)“ an der TU Darmstadt und verdeutlicht das Engagement der Universität, sichere und ethische KI-Technologien voranzutreiben. „LlavaGuard“ wurde entwickelt, um die Sicherheit großer generativer Modelle zu erhöhen, indem Trainingsdaten gefiltert und die Ausgabe problematischer Motive erläutert und begründet werden, wodurch das Risiko der Erzeugung schädlicher oder unangemessener Inhalte verringert wird.

Die Anwendungsmöglichkeiten von „LlavaGuard“ sind weitreichend. Obwohl das Tool sich derzeit noch in der Entwicklung befindet und sich auf die Forschung konzentriert, kann es bereits in Bildgeneratoren wie etwa „Stable Diffusion“ integriert werden, um die Produktion unsicherer Inhalte zu minimieren. Darüber hinaus könnte „LlavaGuard“ in Zukunft auch für den Einsatz auf Social-Media-Plattformen angepasst werden, um Nutzende durch das Herausfiltern unangemessener Bilder zu schützen und so ein sichereres Online-Umfeld zu fördern.

Die Publikation

Lukas Helff, Felix Friedrich, Manuel Brack, Kristian Kersting, Patrick Schramowski: “LLavaGuard: VLM-based Safeguards for Vision Dataset Curation and Safety Assessment”, in: arXiv:2406.05113

Über „RAI“

In den letzten zehn Jahren hat Deep Learning (DL) bedeutende Fortschritte in der Künstlichen Intelligenz ermöglicht, dennoch weisen aktuelle KI-Systeme Schwächen auf, darunter mangelndes logisches Denkvermögen, Schwierigkeiten im Umgang mit neuen Situationen und die Notwendigkeit kontinuierlicher Anpassungen. Nicht zuletzt erfordern aktuelle KI-Systeme umfangreiche Ressourcen. „RAI“ strebt die Entwicklung der nächsten Generation von KI an: KI-Systeme, die mit einer „vernünftigen” Menge an Ressourcen auf Basis „vernünftiger Datenqualität” und „vernünftigen” Datenschutzes lernen. Diese sind mit „gesundem Menschenverstand“ und der Fähigkeit, mit neuen Situationen und Kontexten umzugehen, ausgestattet und basieren auf vernünftigen Trainingsparadigmen, die eine kontinuierliche Verbesserung, Interaktion und Anpassung ermöglichen.

„RAI“ wurde im Rahmen der Exzellenzstrategie des Bundes und der Länder zur Vollantragstellung in der Förderlinie „Exzellenzcluster“ aufgerufen. Insgesamt ist die TU Darmstadt mit drei Projektskizzen im Wettbewerb der Exzellenstrategie vertreten. Neben „RAI“ sind dies „CoM2Life“ zu kommunizierenden Biomaterialien und „The Adaptive Mind“ (TAM) aus dem Bereich der Kognitionswissenschaften.