ARD Story "Gefährliche Intelligenz – Kindesmissbrauch mit KI“

TU-Informatiker Kersting und Schramowski stellen KI-basiertes Sicherheitssystem LlavaGuard vor

2025/12/03

Die aktuelle ARD Story "Gefährliche Intelligenz – Kindesmissbrauch mit KI“ zeigt das unerträgliche Ausmaß, in dem Kriminelle generative KI-Modelle für die Erstellung von kinderpornographischem Material missbrauchen. In erschütternden Interviews wird deutlich, welche Folgen dies für Betroffene und Ermittelnde hat. Aber kann KI auch zur Prävention beitragen? Die TU-Informatiker Prof. Kristian Kersting und Dr. Patrick Schramowski ordnen in der Dokumentation die Rolle der KI ein und stellen ihr KI-basiertes Sicherheitssystem LlavaGuard vor.

Zu den größten Herausforderungen gehört zum einen die große Menge an Material, das durch neue KI-Tools in Sekunden generiert werden kann. Aber auch die unkontrollierte Weitergabe und Anzeige über Social Media-Plattformen ist für Ermittler, Nutzer und Anbieter ein großes Problem.

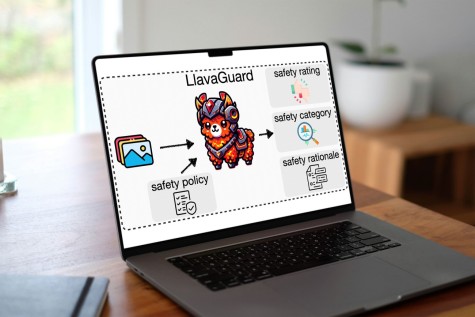

Das Sicherheitssystem LLava-Guard kann Anbieter von KI-Modellen oder Social-Media-Plattformen bei der zuverlässigen Umsetzung von Sicherheitsrichtlinien unterstützen. Kersting und Schramowski haben das Tool gemeinsam mit Lukas Helff sowie den ehemaligen Doktoranden Felix Friedrich und Manuel Brack an Kerstings Fachgebiet Artificial Intelligence and Machine Learing AIML entwickelt.

LlavaGuard

LlavaGuard nutzt Vision-Language-Modelle und kann erstmals bestimmte Bildinhalte von Bildgeneratoren oder in großen Datensätzen filtern, bewerten und unterdrücken:

- Statt einer angeforderten problematischen Szene können beispielsweise automatisch gewaltfreie Alternativen generiert werden.

- Auf Social-Media-Plattformen könnte LlavaGuard unangemessene Bilder herausfiltern und so ein sichereres Online-Umfeld fördern.

Die Methode ist dabei präziser und anpassungsfähiger als andere Systeme und liefert detaillierte Erläuterungen zu ihren Sicherheitsbewertungen. Das ist spätestens seit dem EU AI Act insbesondere für Anbieter von Hochrisiko-KI-Systemen in kritischer Infrastruktur relevant.

Die Forschung zu LlavaGuard ist Bestandteil des Exzellenzclusters "Reasonable Artificial Intelligence (RAI) an der TU Darmstadt. Im Juli stellte das Forscherteam die Ergebnisse auf der renommierten International Conference on Machine Learning (ICML) 2025 vor. Die Wissenschaftler der TU Darmstadt forschen auch am hessian.AI und am DFKI in Darmstadt.

ARD-Story "Gefährliche Intelligenz · Kindesmissbrauch mit KI"

KI-generierte Darstellungen sexualisierter Gewalt an Kindern verbreiten sich online rasant. Mithilfe von frei verfügbaren KI-Modellen entstehen in Sekunden täuschend echte Bilder. Täter trainieren Modelle gezielt mit echter Kinderpornographie und manipulieren harmlose Kinderfotos. Sie tauschen Anleitungen aus und bestärken sich gegenseitig im Einsatz von Künstlicher Intelligenz. Die Bilder sind kein harmloses Spiel: Sie normalisieren Täterverhalten, befeuern die Nachfrage und gefährden Kinder weltweit. (Quelle: ARD)

LlavaGuard

Wer LlavaGuard testen oder einsetzen möchte, findet Modelle und Ressourcen bei Hugging Face.

Publikation

Lukas Helff, Felix Friedrich, Manuel Brack, Kristian Kersting, Patrick Schramowski: “LLavaGuard: VLM-based Safeguards for Vision Dataset Curation and Safety Assessment”, in: arXiv:2406.05113

DOI: https://doi.org/10.48550/arXiv.2406.05113